说到上下文工程启点配资,其实就是在合适的时机把>AI需要的所有东西都给它——指令、示例、数据、工具、历史记录,全部打包塞到模型的输入上下文里。

这么理解会比较直观:语言模型就像CPU,上下文窗口就是工作内存。我们要做的就是往这块内存里装合适比例的代码、数据和指令,让模型能把事情做对。

上下文的来源很多:用户的查询、系统指令、搜索结果、工具输出,还有前面步骤的总结。上下文工程的核心在于把这些碎片实时组装成一个连贯的输入,不是静态的prompt,而是根据任务动态构建的东西。

最近大家对长上下文窗口特别兴奋。新的前沿模型能处理100万token,很多人觉得这就是智能自主agent的终极解决方案。因为这个想法很简单:窗口够大的话,就把所有东西都塞进去——工具、文档、日志、指令、历史,让模型自己处理。

百万token上下文确实感觉像突破。我们可以构建"一次性加载所有内容"的agent:所有工具、所有文档、完整记忆、完整指令。不过这种改进也带来了新问题,叫做"上下文失效"。

这些问题在agent身上表现得最明显,因为agent会随时间积累复杂的长上下文。它们从各个地方收集输入,按顺序调用工具,还要跨多步推理。恰恰在这种场景下,失效会累积。

本文会介绍几个缓解"上下文污染"的方法:先解释>AI agent领域里上下文污染是什么;然后介绍一个在>AI agent中广泛使用的解决方法;最后用langgraph做端到端实现,展示如何缓解上下文污染。

上下文污染是什么上下文污染说白了就是幻觉或错误混进上下文后被当成事实。一旦进去了,模型就会不断引用启点配资,越来越强化这个错误。

对agent来说这特别要命。要是错误事实进入了目标、摘要或记忆,agent可能就会追求不可能的目标,或者重复一些没意义的动作。问题会复利式增长,上下文一旦被污染,修复就很困难。但是好在我们有办法处理。

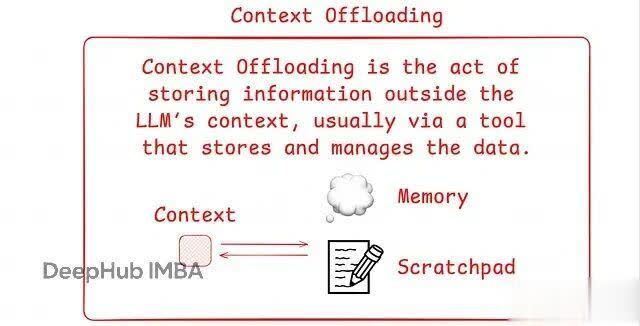

我们用"上下文卸载"(Context Offloading)来缓解上下文污染,这能帮agent保持在正确轨道上。

Context Offloading上下文卸载就是把信息存在语言模型的"活跃上下文窗口"之外。通过外部工具或记忆系统单独保存数据,模型需要时再去访问这些存储的数据。

为什么有用?随着上下文窗口变大,我们可能觉得可以把所有东西都塞进去。但研究表明这会出问题:重要信息埋得太深时,模型使用的准确性会下降——这叫"上下文腐烂"(context rot)。

把关键信息卸载出去,只在需要时检索,我们就避免了模型工作内存的"过载"。这有助于模型保持准确性,减少混乱。

说到实践中的上下文卸载,人类处理复杂任务时会做笔记,agent也开始做类似的事。

Anthropic的研究展示了一个"主agent"先思考任务,然后把计划写入记忆。这样即使上下文窗口变得很大,计划也不会丢失。

Manus有另一个例子:agent把工具输出和任务计划卸载到文件系统。随着agent推进,这些内容会被重复写入和更新。这帮助agent记住目标,而不需要把所有东西都放在活跃上下文里。

实现上下文卸载的方式有很多。比如scratchpad可以是运行时状态的一部分,也可以是写入外部文件的工具调用。

在单次任务中,scratchpad帮agent管理"思路"。在长期交互中,像reflexion和memory这样的方法就派上用场了,让agent能回想起之前会话的有用信息。ChatGPT和Cursor这样的产品用类似的记忆系统在多轮交互中提升表现。

不管哪种情况,核心思想都很简单:agent在会话中存储有用信息,后面需要时再使用。

在LangGraph中,上下文卸载利用"状态对象"在节点间传递数据。这个状态对象就像共享内存或scratchpad。执行过程中,agent可以把重要的笔记、计划或输出写入这个状态。agent的其他部分随后可以在工作流中访问并使用这些数据。

这种结构让我们能管理什么留在模型上下文里,什么要卸载出去。有助于agent保持专注和正确性。

代码示例下面我们来构建一个langgraph agent,它会有这些特性:带scratchpad的agent(可以读写scratchpad来避免上下文污染);上下文卸载工作流(把计划和发现存在模型上下文之外,只在需要时引入);基于工具的研究循环(使用网页搜索和scratchpad存储);LangGraph状态图(管理推理步骤和被卸载的上下文);LangGraph持久化记忆(通过键值存储启用跨线程scratchpad记忆);线程检查点(像聊天线程一样保存中间状态,以便稍后继续)。

Requirements文件

"bs4>=0.0.2启点配资

炒股配资开平台提示:文章来自网络,不代表本站观点。